La nouvelle génération de cartes graphique de NVIDIA est là, et chaque famille possède sa matriarche. Il est temps de savoir si le dernier monstre de l’écurie verte mérite réellement le prix qu’il demande.

New Generation

Dire que les cartes de la série 20 étaient attendues tient de l’euphémisme. Voilà plus de deux ans que l’on attendait une relève digne de la gamme GTX 10 qui avait su délivrer des performances plus que satisfaisantes, touchant du doigt le rêve du gaming en 4K. Autant dire que la nouvelle série 20 avec sa toute nouvelle architecture Turing était attendue au tournant.

Au revoir GTX, bonjour RTX, soulignant une deuxième fois que les choses ne seraient plus jamais comme avant. Ce changement de branding signifie que la nouvelle gamme apporte son lot de nouvelles technologies qui devraient pas mal changer la donne (pour les titres supportés), le ray tracing et le super sampling par deep learning en tant qu’ambassadeurs.

Un Titan qui ne donne pas son nom

Afin d’effectuer nos tests de façon optimale, NVIDIA nous a fourni un PC cordialement prêté par la boutique Cybertek à l’image de la carte : haute de gamme et de dernière génération.

Cybertek Level 9

- Processeur Intel Core i9 9900K

- Memoire Ballistix 32Go DDR4

- Carte graphique RTX 2080Ti 11 Go

- SSD 500Go M2 Samsung

- Disque dur 4 To Seagate

- Watercooling Cooler Master ML120R RGB

Couplé au PC, nous avons utilisé un moniteur ASUS digne de la bête : le ROG Swift PG27UQ, 144Hz G-Sync, 4K HDR.

Impossible d’aborder une carte graphique comme la 2080 Ti sans passer en revue sa fiche technique :

- Coeurs CUDA : 4352

- RTX-OPS : 76 T (14 TFLOPS FP32)

- Rayons par secondes (en ray tracing) : 10 milliards

- Fréquence horloge de base : 1 350 MHz

- Fréquence horloge boosté : 1 545 MHz

- VRAM : 11 Go

- Vitesse VRAM : 14 Gb/s

- Taille bus VRAM : 352-bit

- Bande passante mémoire : 616 Go/s

À cause de l’architecture particulière de la série 20, il faudra désormais prendre en compte de nouveaux paramètres quand on voudra faire le comparatif entre les différentes cartes de la gamme. Grâce aux fameux Tensor Cores, les calculs qui tirent profit du deep learning sont grandement facilités et de nouvelles perspectives sont possibles, comme le ray tracing, dont la performance est généralement exprimée en Gigarays par seconde (milliards de rayons par seconde).

Du côté de l’horloge, rien de bien folichon : 1,545 GHz en mode boost (1,635 pour la version Founder). La taille de la VRAM est également dans les clous des grosses cartes du marché, mais profite d’une nouvelle génération de puces GDDR6 plus véloces.

L’architecture Turing entraîne aussi une autre conséquence surprenante : la RTX 2080 Ti est un très gros beau bébé. Avec sa puce de 7,54 cm², c’est le plus gros GPU jamais conçu pour le grand public par NVIDIA (ce qui peut en partie expliquer le prix de la bête).

Dans mon bench, bench, bench

Maintenant que l’on connaît les caractéristiques du monstre, il est temps de le mettre à l’épreuve.

Commençons par le début : 3DMark avec Time Spy. La séance de test se termine avec un score graphique supérieur à 12500. Comparé à son homologue de la généraiton précédente, la GTX 1080 Ti, cela représente un gain brut de plus de 30%, ce qui est assez bien. Tout à fait de ce qu’on attend d’une nouvelle génération de GPU par rapport à la précédente.

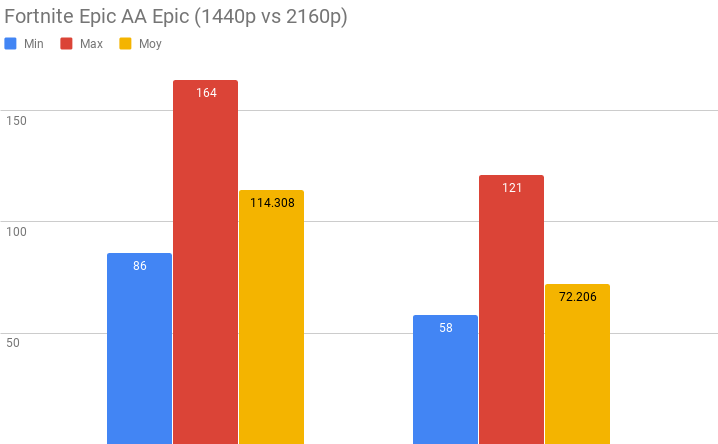

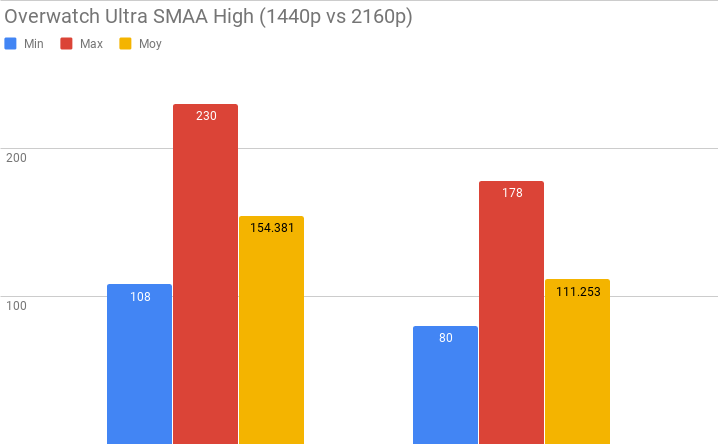

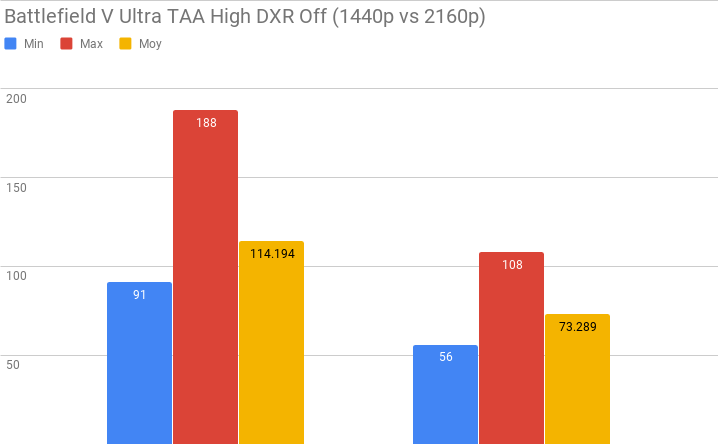

Après un test théorique, il est temps de s’amuser avec quelques jeux. Gourmands et récents, de préférence. Nous concentrerons nos tests sur des résolutions WQHD (1440p) et UHD/4K (2160p), pour les simples raisons qu’acheter une RTX 2080 Ti pour jouer sur du Full HD (1080p) relève de l’overkill, mais surtout parce que les gains de performance dans cette résolution ne sont vraiment pas intéressants : moins de 20% en moyenne comparée à la 1080 Ti, notamment à cause du CPU qui n’arrive plus à suivre. En revanche (et heureusement), dans des résolutions supérieures, ce n’est pas la même limonade.

Pour la petite note, la gestion de l’HDR a été grandement améliorée, son impact étant maintenant assez négligeable comparé à l’ancienne génération.

Les benchmarks suivants ont été réalisés avec le driver 417.71 WHQL (16/01/2019).

Même avec les derniers jeux AAA qui mettent en avant leur technicité graphique, on se rend compte qu’il est enfin possible de jouer en 4K à 60FPS avec tous les potards à fond de manière stable.

On ne pense pas souvent à eux, mais les jeux VR gagnent en fluidité de manière très confortable, voire cruciale. Sur de grosses sessions de jeux VR connus pour leur gourmandise comme Robo Recall ou Elite: Dangerous, il est possible de plafonner les 90FPS (taux de rafraîchissement standard des casques VR) sans un seul ralentissement à déplorer, indispensable pour une expérience VR de qualité. Pire, il est même possible de pousser le vice en supersamplant l’image jusqu’à deux fois pour Elite sans trop de pertes de performance. La 2080 Ti pourrait être un compagnon de choix pour les enthousiastes de la VR qui veulent craquer sur un Vive Pro, voire un Pimax 5K.

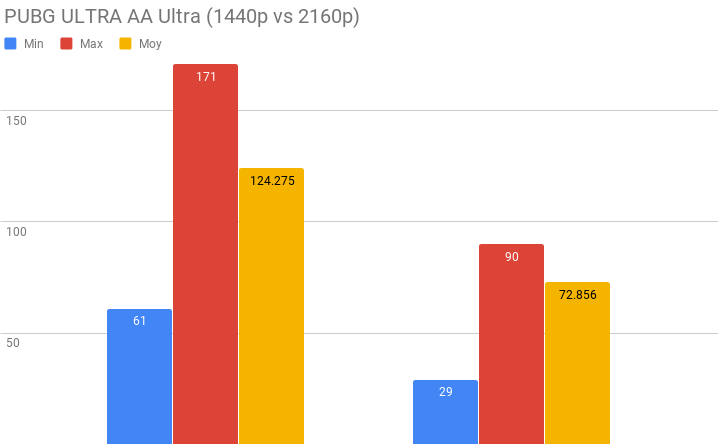

Les joueurs compétitifs en quête de fluidité ne sont également pas en reste. Même PUBG, dont tout le monde rage en permanence de son optimisation, arrive à tourner à un framerate très confortable. Mention spéciale à Overwatch qui atteint très souvent les 120 FPS.

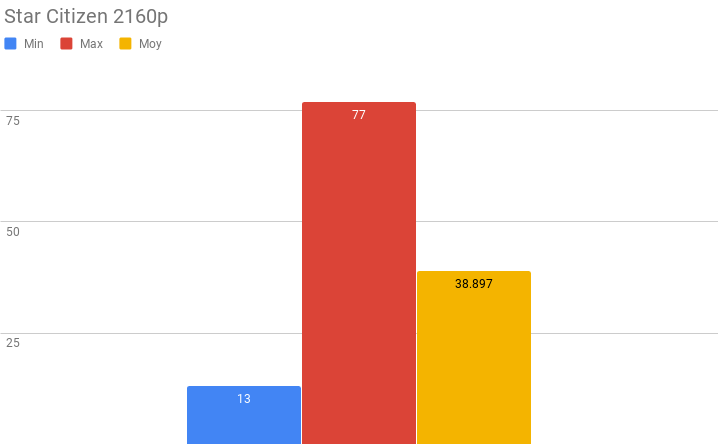

Histoire de tenter de mettre la carte à genou, je l’ai envoyé en pâture à la folie des grandeurs de Chris Roberts : Star Citizen en 4K. Encore en Alpha, le jeu n’est absolument pas optimisé, mais les derniers patchs ont grandement amélioré le framerate grâce à l’introduction de nouvelles technologies en jeu. Dans le vide de l’espace, il n’est pas rare d’atteindre les 60FPS, alors que le site de Lorville fait rapidement chuter le compteur. Mon Super Hornet n’a jamais paru aussi sexy.

S’il est possible d’approcher du sacro-saint 4K/60FPS en général, le résultat n’est pas toujours parfait ou régulier. Pour combler ce problème, NVIDIA a une arme secrète.

Trompe-l’oeil

Les Tensor Cores, ce n’est pas uniquement pour faire joli sur la fiche technique ou de la cryptomonnaie. Pour la première fois, la marque au caméléon compte utiliser la puissance de l’intelligence artificielle pour rendre service au monde du gaming, que ce soit dans le domaine des performances ou de la beauté graphique.

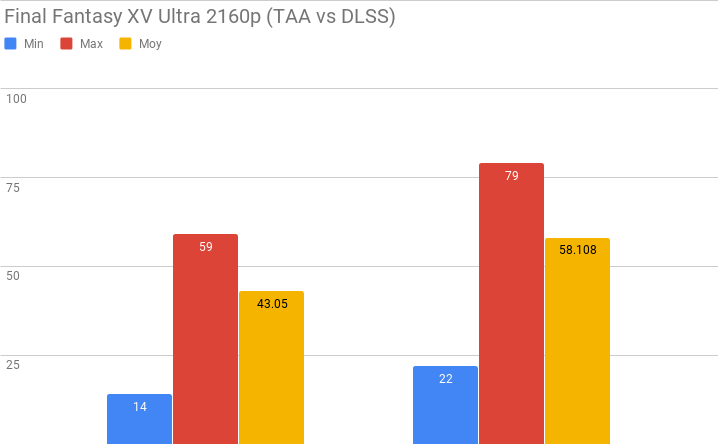

Pour commencer, NVIDIA a présenté le DLSS (pour Deep Learning Super Sampling). Grâce à cette technologie, il est possible de calculer une image en 4K pour une fraction de la puissance normalement nécessaire. Le moteur calcule une image à une résolution inférieure à celle de l’affichage et l’IA prend le relais pour agrandir l’image tout en comblant/interprétant le manque d’information.

Cliquez sur les images pour agrandir.

De ce fait, il ne s’agit en aucun cas de la « vraie » 4K et un détail qui se serait affiché uniquement en natif ne sera pas visible en DLSS. Il en résulte alors un effet de flou global plutôt prononcé quand on en est conscient, mais le résultat est très convaincant comparé à des résolutions inférieures infiniment plus moches, même avec de l’anticrénelage standard. Dès que les images bougent, on y fait plus vraiment attention. Je vous défie de voir la différence si vous ne jouez pas sur un moniteur.

En fait, le vrai problème du DLSS, c’est la compatibilité, puisque seuls certains jeux partenaires seront compatibles avec la techno. Pour le moment, il n’y a que Final Fantasy XV qui prend en compte le super sampling par deep learning, mais pour un gain tout sauf négligeable : presque 40% . En manipulant quelques options graphiques, il y a sûrement moyen d’avoir quelque chose d’optimal.

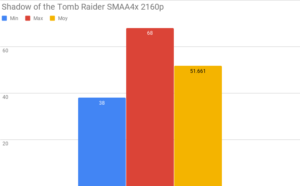

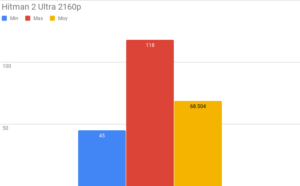

Battlefield V devrait recevoir le support du DLSS dans un avenir proche et Anthem sera compatible dès sa sortie en février. Une vingtaine de jeux devraient être supportés à terme avec des titres déjà sortis comme Hitman 2, Shadow of the Tomb Raider et PUBG. Si les performances gagnées sont au moins aussi intéressantes que sur FFXV, voilà une technologie qui peut faire la différence.

Et la lumière fut

Maintenant, passons au plus gros morceau qui divise : le ray tracing.

Le ray tracing est une autre manière de calculer une image en 3D, et sûrement la première à être inventée. Si elle est s’appuie sur des calculs physiques, comparé à la rastérisation (la méthode classique actuelle), il faut beaucoup énormément de puissance de calcul pour générer une image et les perspectives d’afficher une scène en temps réel sont peu reluisantes. C’est, par exemple, la technique utilisée par les studios d’animation 3D.

L’intérêt graphique se situera alors dans les effets de lumière qui deviennent quasiment photoréalistes, permettant des réflexions, une diffusion et une réfraction à partir de « photons » physiques que l’on aura simulés, sans parler d’effets d’ombres et de prénombres ultra bluffants. Plutôt que d’utiliser des shaders gourmands et limités techniquement, on peut, par exemple, avoir une infinité de réflexions dans un jeu de miroirs sans impacter davantage les performances. On continue d’utiliser la rastérisation pour la géométrie, mais la gestion de la lumière relèvera dorénavant d’une technique physique et réaliste via ray tracing.

D’ailleurs, ILM s’est associé avec Epic Games pour pondre une démo technique très parlante… en plus d’être drôle (que j’ai pu faire tourner sur la carte). Même si cela reste une démo, on en oublie presque que ça tourne en temps réel.

Attention, cela ne veut pas dire que la gamme RTX est aussi puissante que des unités de calculs dans des render farms, mais grâce à l’IA et l’interprétation des données qu’elle peut faire, on peut tricher sur le résultat. Une image très bruitée avec peu de rayons est calculée et les Tensor Cores interviennent pour lisser le tout et rendre le résultat net.

Léger abus de langage quand on parle du ray tracing par NVIDIA, la technologie RTX est en fait une couche qui vient se superposer au DXR (pour DirectX Raytracing) récemment introduit dans DirectX 12, tirant parti des dernières technologies développées par Microsoft et intégrées dans son API graphique.

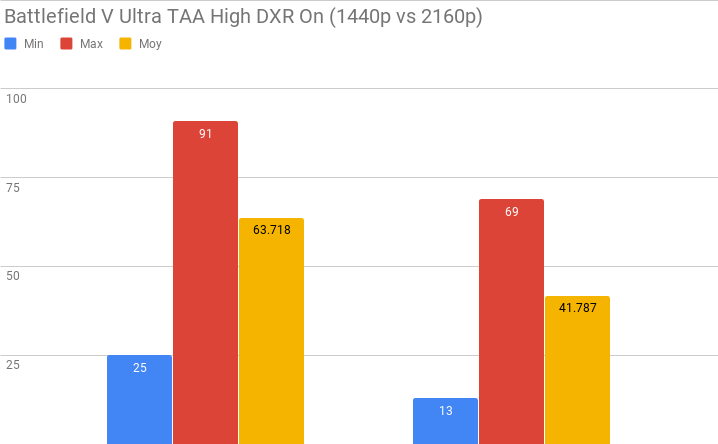

Du coup, pour le jeu vidéo… bah, c’est encore assez difficile à dire, même si la démo d’ILM donne quand même le ton et dévoile un sacré potentiel. Le seul compatible pour l’instant est Battlefield V, et le résultat est mi-figue mi-raisin.

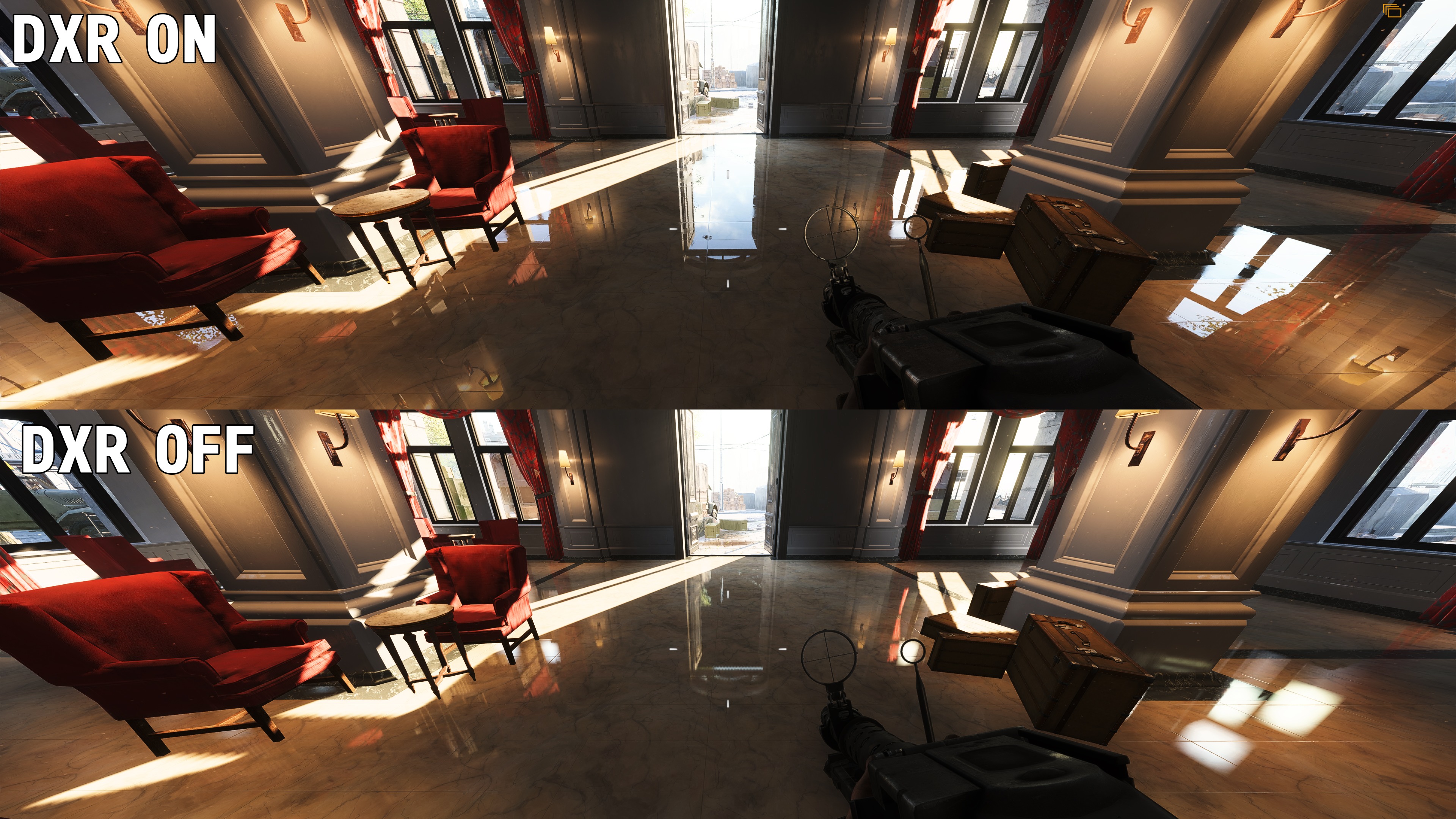

En constatant les données et le ressenti en jeu, non seulement les performances sont divisées par deux, mais le résultat ne saute clairement pas aux yeux. En fait, si, mais il faut savoir où regarder. Si le ray tracing permet sur le papier de faire beaucoup de choses, seules les réflexions de la lumière ont été introduites, n’impactant seulement les étendues d’eau et les surfaces réfléchissantes. Avec la bonne intensité de lumière, même les matériaux qui renvoient peu la lumière comme le bois peuvent donner de jolis reflets, mais le problème inattendu que rencontre le ray tracing dans BFV, c’est que les shaders intégrés au moteur Frostbite faisaient déjà très bien le taffe, ne rendant pas justice à l’apport du DXR.

Si on se penche sur le côté purement technique, c’est quand même le jour et la nuit : il n’y a plus de limite de distance pour qu’une surface réfléchisse une source lumineuse et l’image est bien plus détaillée. Une flaque d’eau va désormais bien refléter le ciel bleu ainsi que les détails aux alentours, et un soldat qui passe à 15 mètres d’une voiture — et même au-delà — sera visible dans sa carrosserie.

Pour le coût en performance que cela implique (surtout sur les cartes avec beaucoup de reflets comme Rotterdam), c’est extrêmement gadget — surtout pour un jeu multi — mais cela prouve que c’est techniquement possible. DICE a eu très peu de temps pour implémenter la technologie (on parle de 15 jours avant l’annonce des cartes en août dernier), mais l’optimisation a déjà fait des progrès ces dernières semaines. De futurs jeux pensés dès le départ pour la technologie devraient normalement être plus convaincants. À noter qu’il est possible de baisser l’intensité du ray tracing et de gagner jusqu’à 15% de performance supplémentaire, sans perdre la distance d’affichage.

Il est donc dommage de ne peut pas avoir introduit l’illumination globale ou les calculs d’ombres réalistes, histoire de se faire une réelle idée. Heureusement, de futurs jeux sont déjà annoncés comme compatibles avec la techno et tirant profit d’autres de ses possibilités. Shadow of the Tomb Raider devrait recevoir un patch sous peu et de futurs jeux attendus, comme Atomic Heart, Metro Exodus ou Mechwarrior 5: Mercenaries ont déjà montré le potentiel du ray tracing lors de diverses présentations.

La cerise sur le gâteau, c’est de savoir que le DLSS pourra être activé en même temps que le ray tracing pour les jeux compatibles, afin de rendre l’expérience, espérons-le, beaucoup plus agréable et fluide. Bien qu’il ne soit pas encore possible de faire des mesures, on suppose que le gain grâce au DLSS ne sera pas aussi spectaculaire que sur un jeu avec le DXR désactivé, étant donné que les deux technologies partagent les mêmes unités de calcul, mais cela devrait tout de même se ressentir. Je sais que ça fait pas mal de speculations pour un test, mais le futur patch DLSS de Battlefield V nous donnera bientôt l’occasion d’en avoir le coeur net

« Nous l’avons appelé, le WOPR »

Indéniablement, la RTX 2080 Ti s’impose comme la nouvelle reine du marché et prouve que la 4K à 60 FPS n’est plus une utopie, malgré un prix moins accessible que ses ancêtres Pascal (cela tend à baisser). Si le gain de performance est plus que correct par rapport au gap générationnel, le DLSS et le ray tracing ont vraiment le potentiel de s’extirper de cette image de gimmick qu’on aime leur donner pour devenir un véritable argument de poids, et Gaben seul sait que j’aimerais m’en moquer. Forcé de constater que, même sur des échantillons qui ne parleront pas au grand public pour l’instant, sur le papier, ça fonctionne. Est-ce que ces technologies basées sur le deep learning arrivent un peu trop tôt ? Peut-être, mais il faut savoir forcer le destin et montrer au reste de l’industrie ce qu’il est déjà techniquement possible de faire pour que le schmilblick avance. On a déjà hâte de découvrir les futurs titres compatibles et s’assurer l’IA a de l’avenir dans le jeu vidéo.

► Points forts

- Des performances étonnantes en 4K

- Le DLSS surprenant

- Une Founder Edition efficace et OC de base

- Prise USB-C pour les casque VR compatibles

► Points faibles

- Le CPU risque de freiner le framerate en 1080p

- Un prix qui n’est pas pour toutes les bourses

- Le ray tracing doit encore faire ses preuves

- Le DLSS et le ray tracing nécessitent des jeux compatibles

- ELLE EST GROSSE SAMÈR

« Et si on faisait une partie d’échecs ? »

Ce test a été réalisé sur un matériel fourni par le constructeur.

Consultez les prix de la NVIDIA GeForce RTX 2080 Ti sur Amazon.fr

Merci pour l’article qui m’en apprend pas ma sur le Ray tracing, concernant la carte j’aurai bien aimé voir la finesse de gravure, le tdp et un prix approximatif pour bien compléter le test, mais il est déjà bien complet :)

Merci pour ton retour <a class=’bp-suggestions-mention’ href=’https://www.warlegend.net/members/valiguard/’ rel=’nofollow’>@Valiguard</a>. J’avoue que j’aurais pu préciser la finesse, mais c’est du 12 nm. Pour le prix, on tourne autour des 1300€ selon les constructeurs (https://amzn.to/2SWZxiw), avec 1100€ pour Zotac.

Pour la consommation, je ne suis malheureusement pas équipé pour faire des mesures, mais de ce que j’ai lu, la consommation serait à peine supérieure à la 1080 Ti, qui se débrouillait déjà très bien.